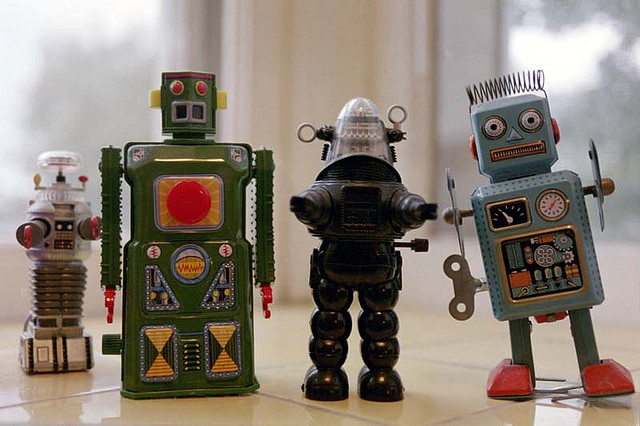

Roboty i moralne aspekty ich decyzji

Zastanawialiście się kiedyś, w jaki sposób myślą roboty? Oczywiście, pierwszą nasuwająca się odpowiedzią jest: nie myślą. Jednak w jakiś sposób również one są zmuszane do wykonywania pewnych czynności oraz podejmowania właściwych decyzji, często w bardzo krótkim czasie. Jasne – to wszystko jest wynikiem programowania. Często jednak dochodzi do sytuacji, w których programiści zwyczajnie nie mają pojęcia dlaczego robot zachował się tak, a nie inaczej.

Zasadniczym elementem tej układanki jest fakt, że roboty myślą zdecydowanie inaczej niż ludzie. Systemy wciąż dopracowywanej sztucznej inteligencji są bowiem tak zaawansowane, że twórcy nie są w stanie przewidzieć zachowania maszyny. Nawet jeżeli robot jest zaprogramowany tak, żeby np. nie krzywdzić istot żywych, to co się stanie w momencie gdy napotka na swej drodze innego robota? Czy będzie on w stanie odróżnić maszynę od człowieka?

Właśnie temu aspektowi postanowili się przyjrzeć inżynierowie i naukowcy z amerykańskiego MIT (Massachusetts Insitute of Technology). W tym celu stworzyli więc tak zwanego debuggera, maszynę odpowiedzialną za kontrolę i eliminowanie ewentualnych błędów kodu innych robotów. Debugger monitoruje więc ich wszystkie procesy decyzyjne oraz potrafi określić, dlaczego robot podjął akurat taką decyzję. W wypadku podjęcia złej, lub braku jakiejkolwiek, kod robota zostaje natychmiast modyfikowany w taki sposób, aby zachowywał się on tak, jak chcą tego twórcy.

Rezultatem takich działań jest naturalnie optymalizacja funkcjonalności robotów. Naukowcy zwracają jednak uwagę na płynące z tego zagrożenie – samodoskonalenie robotów powoduje brak ingerencji człowieka w ich rozwój. Innymi słowy – roboty naprawiają same siebie, a człowiek pomału przestaje być już w tym procesie potrzebny. Science fiction dzieje się dziś.

Leave a Reply